首頁>科技>科學麻辣燙

大型語言模型滲透——人工智能倒逼出版界“立規(guī)矩”

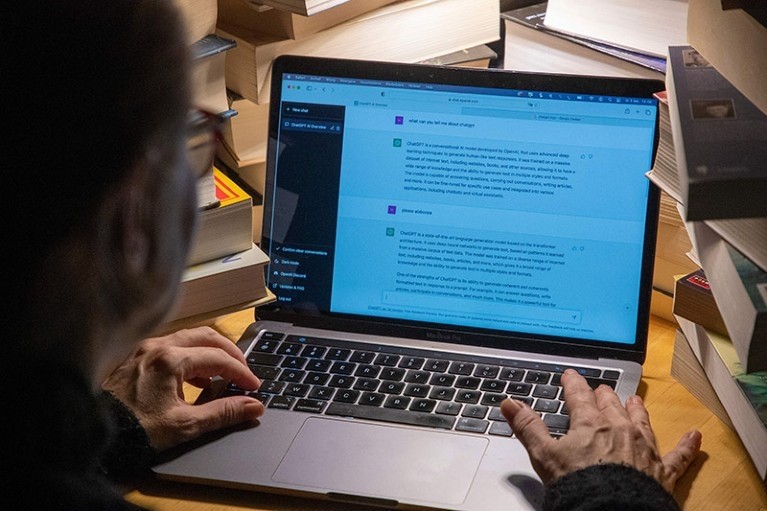

2022年11月,OpenAI發(fā)布生成式人工智能(AI)工具ChatGPT。鑒于生成式AI可快速創(chuàng)建文本、圖像等內容,兩個月后,ChatGPT已作為作者,赫然出現(xiàn)在一些學術論文上。英國紐卡斯爾大學數(shù)字創(chuàng)新研究員薩瓦斯·帕帕揚尼斯表示,在學術界這一競爭激烈的領域,任何能增加研究人員學術產(chǎn)出的工具都是“香餑餑”。

《自然》雜志2023年對科學家開展的一項調查顯示,30%的受訪者使用了生成式AI工具來幫助撰寫論文。圖片來源:《自然》網(wǎng)站

英國《自然》雜志網(wǎng)站在近日的報道中指出,ChatGPT等大型語言模型(LLM)正在重塑科學寫作和出版的面貌。但這些工具在提高生產(chǎn)力的同時,可能也會帶來負面影響。出版商和科學家必須考慮如何更符合倫理道德地使用這些工具,以及過度依賴這些工具將對學術研究前景產(chǎn)生何種影響。

變身科學家“左膀右臂”

LLM可幫助科學家編寫代碼,撰寫文獻綜述,以及開展頭腦風暴。此外,LLM工具也在不斷改進,擁有相關技能的研究人員甚至可以依據(jù)自己的寫作風格和研究領域,開發(fā)出獨屬于自己的個性化LLM。

2023年,《自然》雜志對1600多名科學家進行了一項調查。近30%的受訪者表示,他們曾使用生成式AI工具輔助撰寫論文;約15%的人表示曾使用這些工具幫助撰寫科研經(jīng)費申請書。

在此項調查中,約55%的受訪者認為,生成式AI的一個主要好處是它能為母語非英語的研究人員編輯和翻譯論文。

歐洲研究委員會(ERC)2023年12月開展的一項民意調查也顯示,1000多名ERC資助者中,75%的受助者認為,到2030年,生成式AI工具將減少研究中的語言障礙;85%的人認為生成式AI可承擔重復或勞動密集型任務,如文獻綜述等;38%的人認為生成式AI將提高科學生產(chǎn)力,如幫助研究人員更快撰寫論文。

篩選出有價值論文更難

生成式AI也可能會產(chǎn)生某些與來源無關的荒謬或不真實的內容,這被稱為“幻覺”。

專家認為,LLM有望增加學術產(chǎn)出。這看起來似乎很美,但也會帶來另一個問題:期刊的投稿量大幅增加,導致編輯和同行評審人員不堪重負。帕帕揚尼斯表示,在大量發(fā)表的論文中篩選出有意義的研究已經(jīng)很困難了,如果ChatGPT和其他LLM大幅增加論文產(chǎn)出,從中篩選出有價值的論文將更具挑戰(zhàn)性。

在此環(huán)境下,科研人員應該把工作重點放在寫出真正高水平的論文上。目前學術界“不發(fā)文,就沒門”的模式,要求搞學術研究的人必須快速而持續(xù)地發(fā)表自己的研究論文。但這一點需要改變,學術界應該建立一個新的質量重于數(shù)量的體系。已經(jīng)有機構意識到了這一點,例如,德國研究基金會要求申請者在一份提案中只列出10篇出版物。

出版商為AI制定規(guī)則

隨著生成式AI等工具逐漸滲透學術論文領域,學術出版商開始給其“立規(guī)矩”,發(fā)布有關在寫作過程中如何使用ChatGPT及其他LLM的規(guī)定。1月31日發(fā)表在《英國醫(yī)學雜志》上的一篇論文指出,截至去年10月,100種頂級學術期刊中,有87種提供了有關作者如何使用生成式AI的指導。

例如,施普林格·自然出版集團(自然集團)2023年1月發(fā)布作者指南,新增了兩大原則:首先,ChatGPT等LLM目前不符合作者標準。因為任何作者都要對作品負責,而AI工具無法承擔責任。其次,使用LLM工具的研究人員應在方法或致謝部分列出這種使用。如果一篇論文不包括方法或致謝,作者應當在引言或其他適當位置列出對LLM的使用。

《科學》雜志主編霍頓·索普強調,盡管截至2023年11月,美國科學促進會允許研究人員在撰寫論文手稿時使用生成式AI,但仍然禁止在同行評審期間使用LLM。自然集團也禁止同行評審員將手稿上傳到生成式AI工具中。一些科研撥款機構,包括美國國立衛(wèi)生研究院和澳大利亞研究委員會則出于保密考慮,禁止審查人員使用生成式AI來幫助申請科研經(jīng)費。

盡管研究人員正競相開發(fā)LLM檢測工具,但索普指出,目前還沒有一個檢測工具可產(chǎn)生令人信服的結果,以更好地對期刊投稿進行篩選。

ChatGPT等生成式AI技術不斷發(fā)展,學術界也應找到更好的方法,以便更有效地利用它來促進高質量科研論文的產(chǎn)出,推動科學技術的進步。

編輯:馬嘉悅